조선대 김현일 교수 연구팀, ‘AI 대형 언어모델 지식 저장 구조’ 규명

2025-11-12 14:28

add remove print link

모델별 지식 저장 방식 달라... 맞춤형 AI 학습 기술 발전 기대

[위키트리 광주전남취재본부 노해섭 기자] 조선대학교(총장 김춘성) AI소프트웨어학부 정보통신공학전공 김현일 교수 연구팀이 트랜스포머 기반 대형 언어모델(LLM)의 지식 저장 구조를 분석해, 모델마다 정보를 기억하는 메커니즘이 서로 다르다는 사실을 밝혀냈다.

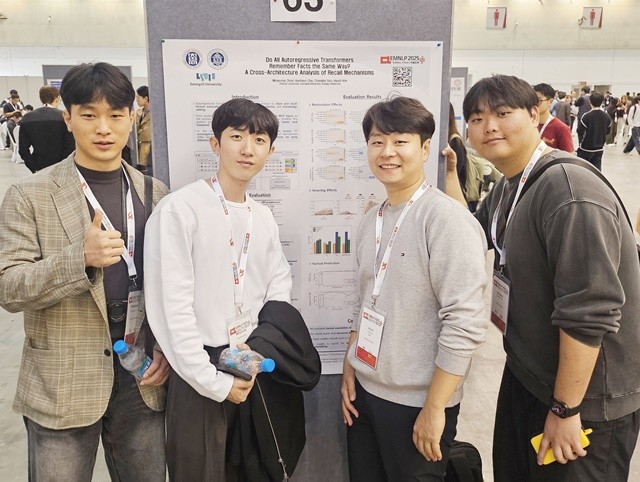

조선대 김현일 교수(교신저자)와 최민영 석사과정생(제1저자)이 참여하고 숭실대·공주대와 공동으로 수행한 이번 연구는 인공지능 및 자연어처리 분야의 세계 최고 권위 학회인 『The 2025 Conference on Empirical Methods in Natural Language Processing(EMNLP 2025)』에 Main(Poster) 트랙으로 발표됐다.

연구팀은 GPT, LLaMA, Qwen 등 대표적인 범용 인공지능(AI) 모델을 비교 분석한 결과, 기존에 알려진 사실과 달리 Qwen 계열 모델은 Attention 구조에 지식을 저장한다는 사실을 밝혀냈다. 이는 모델별 구조적 차이에 따라 학습과 기억 메커니즘이 달라질 수 있음을 입증한 첫 사례다.

이번 성과는 AI가 정보를 학습하고 기억하는 과정을 이해하는 데 중요한 단서를 제공한다. 이를 바탕으로 모델 특성에 맞춘 효율적인 학습·지식 편집 기술 개발이 기대되며, AI가 정보를 해석하고 판단하는 과정을 분석할 수 있는 ‘해석가능성(Interpretability)’연구의 새로운 방향을 제시했다는 점에서도 의미가 크다.

이번 연구는 향후 챗봇·번역기 등 범용 인공지능의 정보 수정 및 응답 정확도 향상 기술은 물론, 기업·공공기관에서 활용되는 산업용 맞춤형 AI 모델의 학습 효율화와 고도화에도 폭넓게 활용될 전망이다.

김현일 교수는 “AI의 내부 작동 원리를 이해함으로써 모델별로 효율적인 학습과 지식 수정이 가능해질 것”이라며, “AI의 신뢰성과 해석가능성을 높이는 데 기여할 것으로 기대된다”고 말했다.

한편, 김현일 교수 연구팀은 해석가능한 AI 연구의 연장선으로 ‘AI 보안성 평가를 위한 백도어 공격 고도화 연구’를 수행했으며, 이는 국제학술지 『IEEE Transactions on Dependable and Secure Computing』(JCR 상위 5%)에 2025년 7월 29일자로 게재(early access)된 바 있다.