전 세계 인터넷 트래픽 추월했다… 초당 '260TB' 전송하는 괴물 칩

2026-01-07 10:32

add remove print link

AI 추론 비용 10분의 1로 급락, 엔비디아 루빈이 바꾼다

엔비디아가 세계 최대 가전·IT 전시회인 CES 무대에서 차세대 AI 컴퓨팅 플랫폼 루빈(Rubin)을 전격 공개하며 인공지능 인프라 시장의 판도를 다시 한번 뒤흔들었다. 이번에 선보인 루빈 플랫폼은 베라 CPU와 루빈 GPU를 포함한 6개의 핵심 칩셋을 유기적으로 통합한 시스템으로, 이전 세대인 블랙웰 플랫폼과 비교해 AI 추론 비용을 최대 10분의 1 수준으로 낮추는 획기적인 효율성을 달성했다.

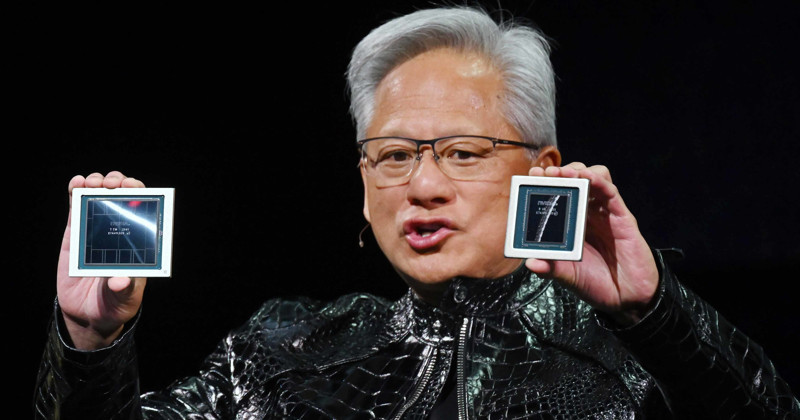

젠슨 황 엔비디아 창립자 겸 CEO는 전례 없이 폭증하는 AI 훈련과 추론 수요를 언급하며 루빈이 AI 컴퓨팅의 새로운 지평을 열 것이라고 자신했다. 플랫폼의 명칭은 우주에 대한 인류의 이해를 넓힌 미국의 천문학자 베라 플로렌스 쿠퍼 루빈의 이름에서 따왔다.

루빈 플랫폼의 기술적 핵심은 하드웨어와 소프트웨어를 극한까지 최적화하여 결합하는 익스트림 코디자인(Extreme Codesign) 전략에 있다. 베라 CPU, 루빈 GPU, NV링크 6 스위치, ConnectX-9 슈퍼NIC, 블루필드-4 DPU, 스펙트럼-6 이더넷 스위치 등 6종의 신형 칩이 하나의 유기체처럼 작동한다. 이러한 통합 설계 덕분에 전문가 혼합 모델(MoE, 여러 전문화된 AI 모델을 결합해 성능을 높이는 기술)을 훈련할 때 필요한 GPU 수를 기존 대비 4분의 1로 줄일 수 있게 되었다.

개별 칩셋의 성능 수치도 압도적이다. 6세대 NV링크는 GPU 간 통신 속도를 비약적으로 높여 GPU당 초당 3.6테라바이트의 대역폭을 제공한다. 랙 단위인 베라 루빈 NVL72 시스템으로 확장하면 초당 260테라바이트라는 천문학적인 데이터 전송이 가능해진다. 이는 전 세계 인터넷 트래픽을 합친 것보다 많은 양이다. 베라 CPU는 88개의 커스텀 올림푸스 코어를 탑재하여 암(Arm) 기반 아키텍처의 호환성을 유지하면서도 전력 효율을 극대화했다. 추론 연산을 담당하는 루빈 GPU는 3세대 트랜스포머 엔진을 장착해 50페타플롭스의 연산 능력을 발휘한다.

보안과 유지보수 측면의 진화도 눈여겨볼 만하다. 베라 루빈 NVL72는 랙 스케일 플랫폼 최초로 기밀 컴퓨팅(Confidential Computing) 기술을 적용했다. CPU와 GPU, 그리고 이를 연결하는 NV링크 등 데이터가 이동하는 모든 경로에서 암호화 상태를 유지해 기업의 민감한 데이터를 보호한다. 또한 케이블을 없애고 모듈형 트레이 방식을 채택하여 시스템 조립과 수리 속도를 블랙웰 대비 18배나 단축했다.

데이터센터의 혈관 역할을 하는 네트워킹 기술에는 스펙트럼-X 이더넷 포토닉스가 도입됐다. 빛을 이용해 신호를 전달하는 이 기술은 전력 효율을 5배 높이고 시스템 가동 시간을 획기적으로 연장한다. 함께 공개된 AI 네이티브 스토리지 플랫폼은 블루필드-4 DPU를 통해 AI가 추론할 때 필요한 문맥 데이터를 효율적으로 저장하고 공유하도록 돕는다. 이는 AI가 단답형 답변을 넘어 복잡하고 긴 호흡의 과제를 수행하는 에이전트 AI로 진화하는 데 필수적인 인프라다.

글로벌 빅테크 기업들의 움직임은 이미 분주하다. 마이크로소프트는 차세대 AI 데이터센터인 페어워터(Fairwater) 프로젝트에 베라 루빈 NVL72 시스템을 도입해 수십만 개의 슈퍼칩을 연동할 계획이라고 밝혔다. AWS와 구글 클라우드, 오라클 등 주요 클라우드 사업자들도 2026년 도입을 확정 지었다. AI 클라우드 전문 기업인 코어위브(CoreWeave) 역시 루빈 시스템을 도입해 다양한 AI 워크로드를 처리할 수 있는 유연한 인프라를 구축하겠다고 선언했다.

소프트웨어 생태계 확장도 동시에 진행된다. 레드햇은 엔비디아와 협력을 확대해 루빈 플랫폼에 최적화된 리눅스와 오픈시프트 등 AI 소프트웨어 스택을 제공하기로 했다.